Zweck dieses Leitfadens ist die Vermittlung der Grundlagen zu den wichtigsten Verfahren der Partikelcharakterisierung, die derzeit in Industrie und Forschung eingesetzt werden. Es werden keine Vorkenntnisse in der Theorie der Partikelcharakterisierung oder zu den dazu verwendeten Geräten vorausgesetzt.

Zweck dieses Leitfadens ist die Vermittlung der Grundlagen zu den wichtigsten Verfahren der Partikelcharakterisierung, die derzeit in Industrie und Forschung eingesetzt werden. Es werden keine Vorkenntnisse in der Theorie der Partikelcharakterisierung oder zu den dazu verwendeten Geräten vorausgesetzt. Der Leitfaden eignet sich damit ideal für Einsteiger in die Partikelcharakterisierung oder für Personen, die ihre Kenntnisse auf diesem Gebiet vertiefen möchten. Der Leitfaden umfasst einführende Grundlagen, die Theorie der Partikelcharakterisierung und die dazu verwendeten Geräte sowie eine Kurzreferenz, die Ihnen bei der Entscheidung hilft, welche Verfahren der Partikelcharakterisierung für Ihre Anforderungen am besten geeignet sind. Es sind nicht alle Partikelcharakterisierungstechniken beschrieben; Weitere Informationen finden Sie unter www.malvernpanalytical.com.

Grundsätzlich kann ein Partikel als diskrete Untereinheit einer Substanz definiert werden. Im Rahmen dieses Leitfadens grenzen wir diese Definition auf Feststoffpartikel, Flüssigkeitstropfen oder Gasblasen ein, deren Abmessungen vom Subnanometerbereich bis zu mehreren Millimetern reichen.

Es gibt zwei wesentliche Gründe, warum der routinemäßige Einsatz der Partikelcharakterisierung in vielen Branchen Anwendung findet.

In einer zunehmend wettbewerbsorientierten globalen Wirtschaft liefert eine bessere Kontrolle der Produktqualität echte wirtschaftliche Vorteile:

Zusätzlich zur Kontrolle der Produktqualität bietet ein besseres Verständnis der Auswirkung von Partikeleigenschaften auf Ihre Produkte, Inhaltsstoffe und Prozesse folgende Möglichkeiten:

Zusätzlich zur chemischen Zusammensetzung wird das Verhalten von partikulären Materialien häufig durch die physikalischen Eigenschaften der einzelnen Partikel bestimmt. Diese können eine weite Spanne von Eigenschaften beeinflussen, wie z. B. Reaktions- und Auflösungsgeschwindigkeiten, das Fließ- und Mischungsverhalten oder die Kompressibilität und Abrasivität. Aus der Perspektive der Entwicklung und Fertigung gehören zu den wichtigsten zu messenden physikalischen Eigenschaften:

Abhängig vom entsprechenden Material können einige oder alle dieser Eigenschaften wichtig sein, und sie könnten sogar in Wechselbeziehung stehen, wie z. B. Oberfläche und Partikelgröße. Im Rahmen dieses Leitfadens konzentrieren wir uns auf zwei der wichtigsten und am einfachsten zu messenden Eigenschaften: Partikelgröße und Partikelform.

Die mit Abstand wichtigste physikalische Eigenschaft von Partikelproben ist die Partikelgröße. Die Messung der Partikelgröße wird in einer Vielzahl von Branchen durchgeführt und stellt häufig einen entscheidenden Parameter bei der Produktherstellung dar. Die Partikelgröße hat einen direkten Einfluss auf Materialeigenschaften wie:

Die Messung der Partikelgröße und das Verständnis ihrer Auswirkungen auf die Produkte und Prozesse können für den Erfolg der Materialherstellung entscheidend sein.

Partikel sind dreidimensionale Objekte, und soweit sie keine perfekte Kugelform aufweisen (wie z. B. bei Emulsionen oder Blasen), können sie durch eine einzelne Dimension, wie einen Radius oder Durchmesser, nicht vollständig beschrieben werden.

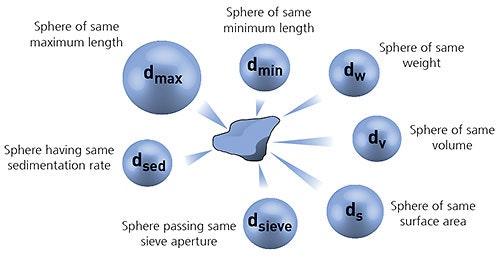

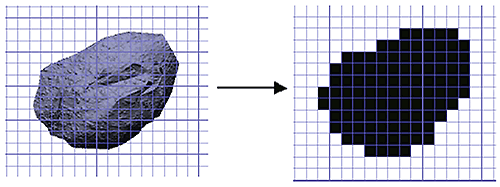

Um den Messvorgang zu vereinfachen, ist es häufig zweckmäßig, die Partikelgröße mittels des Konzepts der äquivalenten Kugeln zu definieren. IIn diesem Fall wird die Partikelgröße anhand des Durchmessers einer äquivalenten Kugel definiert, die dieselbe Eigenschaft wie das tatsächliche Partikel aufweist, wie z. B. Volumen oder Masse. Zu beachten ist, dass die unterschiedlichen Messverfahren unterschiedliche Kugeläquivalenzmodelle verwenden und daher nicht zwangsweise genau dasselbe Ergebnis für den Partikeldurchmesser liefern.

Abbildung 1: Veranschaulichung des Konzepts der äquivalenten Kugeln.

Das Konzept der äquivalenten Kugeln eignet sich sehr gut für regelmäßig geformte Partikel. Für unregelmäßig geformte Partikel, wie Nadeln oder Plättchen, ist es jedoch nicht immer zutreffend, da hier die Größe in mindestens einer Dimension erheblich von den anderen Dimensionen abweichen kann.

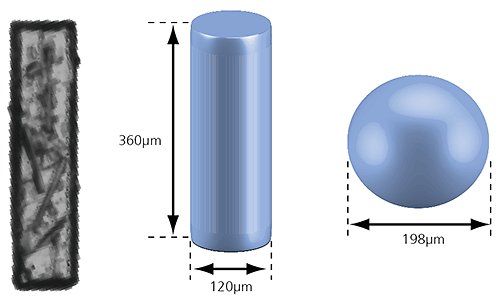

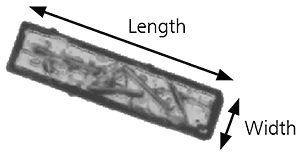

Abbildung 2: Veranschaulichung eines volumenäquivalenten Zylinders bzw. einer volumenäquivalenten Kugel für ein nadelförmiges Partikel.

Im Falle des in obiger Abbildung gezeigten stabförmigen Partikels entspräche eine volumenäquivalente Kugel einem Partikeldurchmesser von 198 µm und damit keiner sehr realitätsgetreuen Beschreibung seiner wahren Abmessungen. Wir können das Partikel jedoch auch als volumenäquivalenten Zylinder definieren, der eine Länge von 360 µm und eine Breite von 120 µm aufweist. Dieser Ansatz beschreibt die Größe des Partikels genauer und kann ein besseres Verständnis dafür liefern, wie sich dieses Partikel z. B. bei der Verarbeitung und Handhabung verhält.

Viele Verfahren der Partikelgrößenbestimmung basieren auf einem einfachen Konzept der eindimensionalen Messung des Kugeläquivalentdurchmessers. Häufig ist dies für die erforderliche Anwendung vollkommen ausreichend. Die Messung der Partikelgröße in zwei oder mehr Dimensionen kann mitunter wünschenswert sein, kann jedoch auch größere messtechnische und datenanalytische Herausforderungen bergen. Daher ist bei der Auswahl des am besten geeigneten Verfahrens der Partikelgrößenbestimmung für Ihre Anwendung eine sorgfältige Abwägung ratsam.

Sofern die zu charakterisierende Probe nicht perfekt monodispers ist, d. h., jedes einzelne Partikel genau dieselben Abmessungen aufweist, besteht sie aus einer statistischen Verteilung von Partikeln unterschiedlicher Größen. Es ist üblich, eine solche Verteilung in der Form einer Häufigkeitsverteilungskurve oder einer Summenverteilungskurve darzustellen.

Im Hinblick auf die Gewichtung der einzelnen Partikel kann eine Partikelgrößenverteilung auf unterschiedliche Arten dargestellt werden. Der Gewichtungsmechanismus ist von dem verwendeten Messprinzip abhängig.

Ein Zählverfahren wie z. B. die Bildanalyse ergibt eine anzahlgewichtete Verteilung, bei der jedes Partikel unabhängig von seiner Größe die gleiche Gewichtung erhält. Eine solche Gewichtung ist dann besonders nützlich, wenn es wichtig ist, die absolute Anzahl der Partikel zu kennen, wie z. B. bei der Erkennung von Fremdpartikeln oder wenn eine hohe partikelspezifische Auflösung erforderlich ist.

SLS-Verfahren (statische Lichtstreuung) wie z. B. die Laserbeugung ergeben eine volumengewichtete Verteilung. Hierbei steht der Beitrag eines jeden Partikels in der Verteilung im Zusammenhang mit dem Volumen dieses Partikels (bei einheitlicher Dichte äquivalent zur Masse), d. h., der relative Beitrag ist proportional zu (Größe)3. Aus wirtschaftlicher Sicht ist dieser Zusammenhang häufig äußerst nützlich, da die Verteilung die Zusammensetzung der Probe hinsichtlich ihres Volumen-Masse-Verhältnisses angibt und daher einen potenziellen Geldwert beschreibt.

DLS-Verfahren (dynamische Lichtstreuung) ergeben eine intensitätsgewichtete Verteilung, bei der der Beitrag des einzelnen Partikels in der Verteilung mit der Intensität des von dem Partikel gestreuten Lichts im Zusammenhang steht. Wird z. B. die Rayleigh-Näherung verwendet, ist der relative Beitrag bei sehr kleinen Partikeln proportional zu (Größe)6.

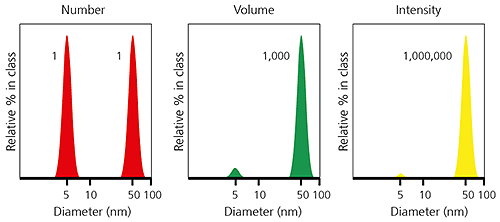

Beim Vergleich von Partikelgrößendaten, die an derselben Probe mittels verschiedenen Verfahren gemessen wurden, ist zu beachten, dass die Arten der gemessenen und protokollierten Verteilungen zu sehr unterschiedlichen Partikelgrößenergebnissen führen können. Deutlich veranschaulicht wird dies im nachstehenden Beispiel einer Probe, die aus einer gleichen Anzahl von Partikeln mit Durchmessern von jeweils 5 nm und 50 nm besteht. Die anzahlgewichtete Verteilung ergibt eine gleiche Gewichtung beider Partikeltypen. Dadurch wird das Vorhandensein der feineren 5 nm Partikel hervorgehoben. Die intensitätsgewichtete Verteilung hingegen weist für die gröberen 50 nm Partikel ein um einen Faktor von 1 Mio. stärkeres Signal auf. Die volumengewichtete Verteilung ist zwischen diesen beiden einzuordnen.

Abbildung 3: Beispiel für anzahl-, volumen- und intensitätsgewichtete Partikelgrößenverteilungen für dieselbe Probe.

Die Partikelgrößendaten können von einer Verteilungsart zu einer anderen umgewandelt werden. Hierzu müssen jedoch zur Form des Partikels und zu seinen physikalischen Eigenschaften bestimmte Annahmen getroffen werden. Man sollte z. B. nicht unbedingt erwarten, dass eine volumengewichtete Partikelgrößenverteilung, die mittels Bildanalyse gemessen wurde, exakt mit einer Partikelgrößenverteilung übereinstimmt, die mittels Laserbeugung gemessen wurde.

„Es gibt drei Arten von Lügen: Lügen, verdammte Lügen und Statistiken.“

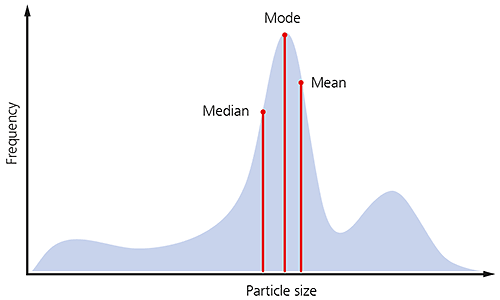

Um die Interpretation der Daten zur Partikelgrößenverteilung zu vereinfachen, kann eine Vielzahl statistischer Parameter berechnet und protokolliert werden. Die Auswahl der am besten geeigneten statistischen Parameter für eine bestimmte Probe hängt davon ab, wie diese Daten verwendet werden und mit was sie verglichen werden sollen. Falls Sie z. B. die häufigste Partikelgröße in Ihrer Probe protokollieren möchten, haben Sie die Wahl zwischen folgenden Parametern:

• Mittelwert - durchschnittliche Größe einer Population

• Median - Größe, die von 50 % der Population unter- bzw. überschritten wird

• Modal Wert - Größe mit der höchsten Häufigkeit

Wenn die Form der Partikelgrößenverteilung asymmetrisch ist, wie es bei vielen Proben häufig der Fall ist, würde man nicht erwarten, dass diese drei Werte genau übereinstimmen, wie nachfolgend veranschaulicht.

Abbildung 4: Veranschaulichung des Medians, Modus und Mittelwerts einer Partikelgrößenverteilung.

Es existieren viele unterschiedliche Mittelwerte, deren Definition sich darin unterscheidet, wie die Verteilungsdaten erfasst und analysiert werden. Die drei bei der Partikelgrößenbestimmung am häufigsten verwendeten Werte werden nachfolgend beschrieben.

1. Arithmetischer Mittelwert D[1,0] oder Xnl

Der arithmetische Mittelwert hat dann besondere Bedeutung, wenn die Anzahl der Partikel von Interesse ist, wie z. B. bei Anwendungen zur Partikelzählung. Er kann nur berechnet werden, wenn die Gesamtanzahl der Partikel in der Probe bekannt ist, und ist daher auf Anwendungen zur Partikelzählung begrenzt.

2. Sauterdurchmesser D[3, 2] oder Xsv

Der Sauterdurchmesser ist am meisten relevant, wenn die spezifische Oberfläche wichtig ist, wie z. B. für die Bioverfügbarkeit, Reaktivität oder Auflösung. Er ist stark abhängig von dem Vorhandensein feiner Partikel in der Größenverteilung.

3. De-Brouckere-Durchmesser D[4, 3] oder Xvm

Der De-Brouckere-Durchmesser ist für viele Proben relevant, da er die Größe der Partikel wiedergibt, die den größten Anteil des Probenvolumens bilden. Er ist stark abhängig von dem Vorhandensein größerer Partikel in der Größenverteilung.

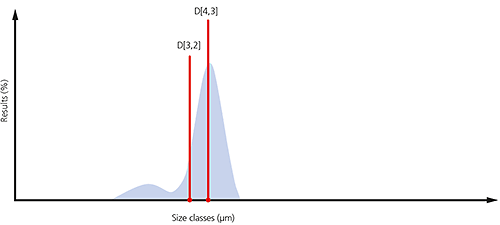

Beispiele des Sauterdurchmessers und des De-Brouckere-Durchmessers sind in der nachstehenden Partikelgrößenverteilung dargestellt. Falls es darum geht, die Größe der groben Partikel zu überwachen, aus denen der größte Anteil dieser Probe besteht, ist D[4,3] am geeignetsten. Wenn es andererseits wichtiger ist, den Anteil der vorhandenen feinen Partikel zu überwachen, kann die Verwendung von D[3,2] zweckmäßiger sein.

Abbildung 5: Veranschaulichung der Werte D[4,3] und D[3,2] einer Partikelgrößenverteilung, in der ein erheblicher Feinanteil vorhanden ist.

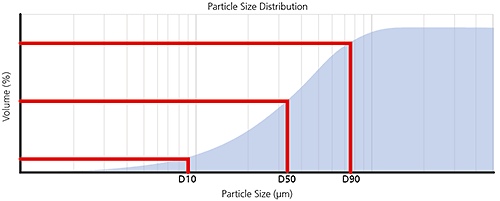

Bei volumengewichteten Partikelgrößenverteilungen, wie sie z. B. mittels Laserbeugung gemessen werden, ist es häufig zweckmäßig, Parameter zu protokollieren, die die maximale Partikelgröße für einen bestimmten Volumenprozentanteil der Probe wiedergeben.

Perzentile sind definiert als XaB, wobei gilt:

X = Parameter, üblicherweise D für den Durchmesser

a = Gewichtung der Verteilung, z. B. n für Anzahl (von engl. number), v für Volumen, i für Intensität

B = Prozentsatz der Probe unterhalb dieser Partikelgröße, z. B. 50 %, mitunter als Dezimalbruch geschrieben, z. B. 0,5

Das Perzentil Dv50 würde z. B. den maximalen Partikeldurchmesser angeben, unterhalb dem 50 % des Probenvolumens vorliegen. Dies wird auch als die volumenbezogene Median-Partikelgröße bezeichnet.

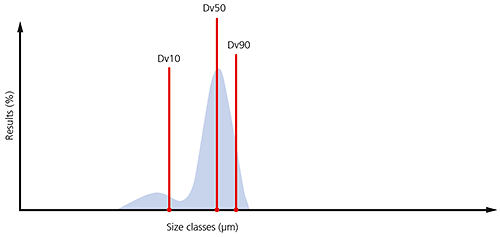

Die am häufigsten protokollierten Perzentile sind Dv10, Dv50 und Dv90. Diese sind in den nachfolgenden Häufigkeitsverteilungs- und Verteilungssummenkurven veranschaulicht.

Abbildung 6: Veranschaulichung der Volumenperzentile anhand von Häufigkeitsverteilungs- und Verteilungssummenkurven.

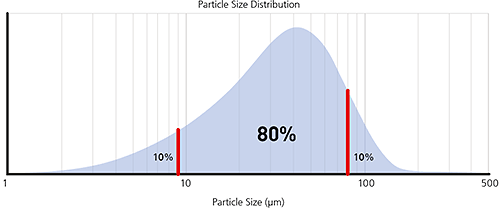

Durch Überwachung dieser drei Parameter kann festgestellt werden, ob signifikante Änderungen bei der vorwiegenden Partikelgröße bzw. Änderungen bei den Extremwerten der Verteilung vorliegen. Dies könnte auf das Vorhandensein von feinen Partikeln oder übergroßen Partikeln/Agglomeraten zurückzuführen sein, wie in der nachstehenden Partikelgrößenverteilung dargestellt.

Abbildung 6: Veranschaulichung der Perzentile Dv10, Dv50 und Dv90 bei einer typischen Partikelgrößenverteilung, in der ein signifikanter Feinanteil vorhanden ist.

Ebenso wie die Partikelgröße kann auch die Form der einzelnen Partikel einen erheblichen Einfluss auf die Performance oder das Prozessverhalten partikulärer Materialien haben. In vielen Branchen werden heute auch Messungen der Partikelform zusätzlich zu denen der Partikelgröße durchgeführt, um ein besseres Verständnis der Produkte und Prozesse zu erlangen. Zu den Eigenschaften, auf die die Partikelform Einfluss haben kann, gehören:

Anhand der Partikelform kann auch der Dispergierzustand von partikulären Materialien bestimmt werden, insbesondere wenn Agglomerate oder Primärpartikel vorhanden sind.

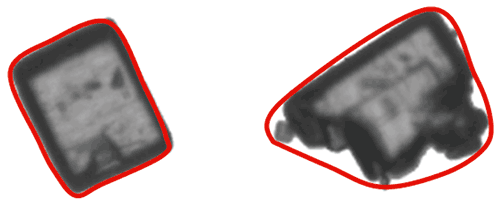

Partikel sind komplexe dreidimensionale Objekte. Daher sind wie bei der Messung der Partikelgröße Vereinfachungen der Partikelbeschreibung erforderlich, um die Messung und Datenanalyse zu ermöglichen. Die Partikelform wird meistens mittels bildgebender Verfahren gemessen. Hierbei werden Daten erfasst, die einer zweidimensionalen Projektion des Partikelprofils entsprechen. Die Partikelformparameter können aus dieser zweidimensionalen Projektion mittels einfacher geometrischer Berechnungen bestimmt werden.

Abbildung 8: Umwandlung eines Partikelbilds in eine zweidimensionale binäre Projektion für die Formanalyse.

Die Gesamtform eines Partikels kann anhand relativ einfacher Parameter charakterisiert werden, wie z. B. des Breiten-Längen-Verhältnisses. Wenn wir als Beispiel das nachstehende Partikelbild heranziehen, kann das Breiten-Längen-Verhältnis einfach definiert werden als:

Breiten-Längen-Verhältnis = Breite/Länge

Abbildung 9: Veranschaulichung der Länge und Breite bei einem nadelförmigen Partikel.

Anhand des Breiten-Längen-Verhältnisses kann zwischen Partikeln unterschieden werden, die eine regelmäßige Symmetrie aufweisen, wie z. B. Kugeln oder Würfeln, und Partikeln mit unterschiedlichen Abmessungen entlang einer Achse, wie z. B. nadel- oder eiförmigen Partikeln. Zu den weiteren Formparametern, anhand deren die Partikelform charakterisiert werden kann, gehören Dehnung und Rundheit.

Ebenso wie der Nachweis agglomerierter Partikel kann auch die Kontur von Partikeln Informationen über Eigenschaften wie die Oberflächenrauheit liefern. Zur Berechnung von Partikelkonturparametern wird ein Konzept verwendet, das als Umfang der konvexen Hülle bezeichnet wird. Vereinfacht dargestellt wird der Umfang der konvexen Hülle anhand eines imaginären elastischen Bands berechnet, das um die Kontur des Partikelbilds gespannt wird, wie in der nachstehenden Abbildung veranschaulicht.

Abbildung 10: Veranschaulichung der konvexen Hülle für zwei unterschiedliche Partikelformen.

Nachdem der Umfang der konvexen Hülle berechnet wurde, können darauf aufbauend Parameter definiert werden, wie die Konvexität und Solidität. Hierbei gilt:

• Konvexität = Umfang der konvexen Hülle/tatsächlicher Umfang

• Solidität = Flächeninhalt des tatsächlichen Umfangs/Flächeninhalt des Umfangs der konvexen Hülle

Partikel mit sehr glatten Konturen weisen Konvexitäts-/Soliditätswerte nahe 1 auf. Partikel mit groben Konturen oder agglomerierte Primärpartikel hingegen weisen dementsprechend niedrigere Konvexitäts-/Soliditätswerte auf.

Manche Formparameter erfassen sowohl Änderungen der Partikelform als auch der Partikelkontur. Eine Überwachung dieser Parameter kann zweckmäßig sein, wenn sowohl Form als auch Kontur Auswirkungen auf das Verhalten des zu messenden Materials haben. Der am häufigsten verwendete Parameter ist die Zirkularität. Hierbei gilt:

• Zirkularität* = Umfang/Umfang einer äquivalenten Kreisfläche

*Mitunter lautet die Definition auch: (Umfang/Umfang einer äquivalenten Kreisfläche)2

Dieser Parameter wird auch als HS-Zirkularität bezeichnet, um eine Verwechslung mit der obigen Definition zu vermeiden.

Die Zirkularität dient häufig dazu, zu messen, wie nahe ein Partikel einer perfekten Kugel gleichkommt. Sie kann zur Überwachung von Eigenschaften wie dem Abrasivpartikelverschleiß dienen. Bei der Interpretation der Daten ist jedoch Vorsicht geboten, da jegliche Abweichungen auf Änderungen der Oberflächenrauheit oder der physischen Form oder beider Eigenschaften zurückzuführen sein können.

Wenngleich die Zirkularität für manche Anwendungen sehr nützlich sein kann, ist sie nicht für alle Situationen geeignet. Bis heute existiert noch keine Definition eines universellen Formparameters, der in jedem Fall anwendbar ist. Vielmehr bedarf es sorgfältiger Abwägung, um den am besten geeigneten Parameter für eine spezifische Anwendung zu bestimmen.

Das Zetapotenzial ist ein Maß für die Größenordnung der elektrostatischen Abstoßung oder Anziehung zwischen Partikeln in einer Flüssigsuspension. Es ist einer der fundamentalen Parameter für die Dispersionsstabilität. Die Messung des Zetapotenzials liefert detaillierte Einblicke in die Mechanismen von Dispersion, Aggregation und Ausflockung und kann zur Verbesserung der Rezeptur von Dispersionen, Emulsionen und Suspensionen eingesetzt werden.

Die Schnelligkeit, mit der neue Rezepturen auf dem Markt eingeführt werden können, ist der Schlüssel zum Produkterfolg. Die Messung des Zetapotenzials ist eine der Methoden zur Verkürzung der Stabilitätsprüfung durch Verringerung der infrage kommenden Rezepturen. Somit können durch die Messung nicht nur Zeit und Kosten minimiert, sondern auch die Haltbarkeit verbessert werden.

Bei der Wasserbehandlung können durch die Überwachung der Dosierung der chemischen Additive mithilfe von Zetapotenzialmessungen deren Dosierung optimiert und somit die Kosten gesenkt werden.

Die Messung des Zetapotenzials hat bedeutende Anwendungen in einer Vielzahl von Branchen, darunter Keramik, Pharmazeutika, Medizin, Mineralverarbeitung, Elektronik und Wasserbehandlung.

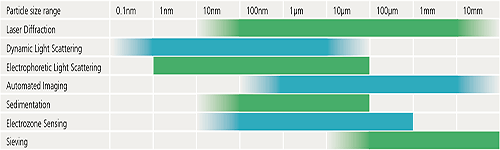

Es gibt eine große Auswahl kommerziell verfügbarer Verfahren zur Partikelcharakterisierung, die zur Messung von Partikelproben eingesetzt werden können. Jedes hat seine relativen Stärken und Einschränkungen. Ein für alle Proben und Situationen universell anwendbares Verfahren existiert nicht.

Für die Entscheidung, welche Verfahren zur Partikelcharakterisierung benötigt werden, sind eine Reihe von Kriterien zu berücksichtigen:

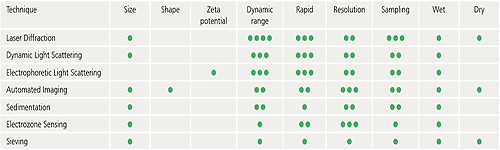

Die folgende Tabelle führt einige grundsätzliche Richtlinien auf, um Ihnen bei der Entscheidung zu helfen, welche der gängigeren Verfahren für eine bestimmte Anwendung am besten geeignet sein könnten. Die angegebenen Partikelgrößenbereiche dienen nur als Richtwerte. Die exakten Spezifikationen können je nach Gerät variieren.

Praktisch alle Verfahren der Partikelcharakterisierung erfordern zur Durchführung der Messung ein gewisses Maß an Probenteilung. Selbst bei Anwendungen zur Partikelzählung, bei denen z. B. der gesamte Inhalt einer Spritze gemessen wird, wird nur ein kleiner Anteil aller Spritzen einer Produktionslinie untersucht.

Es sei daran erinnert, dass die Ursache von Problemen mit unzuverlässigen Messungen sehr häufig in der Probenahme zu finden ist. Daher ist es wichtig, dass die im Gerät gemessene Teilprobe möglichst repräsentativ für die gesamte Charge ist.

Wenn die Geräte eine Präsentation der Probe als stabile Dispersion erfordern (wie z. B. bei der Laserbeugung), werden die Auswirkungen von Probenahmeproblemen durch Homogenisieren, Rühren und Umwälzen des Materials minimiert. Mit dieser Vorgehensweise allein kann jedoch nicht die Aufgabe bewältigt werden, einer 10.000 kg Charge eine repräsentative 10 g Probe zu entnehmen, um ein Beispiel zu nennen.

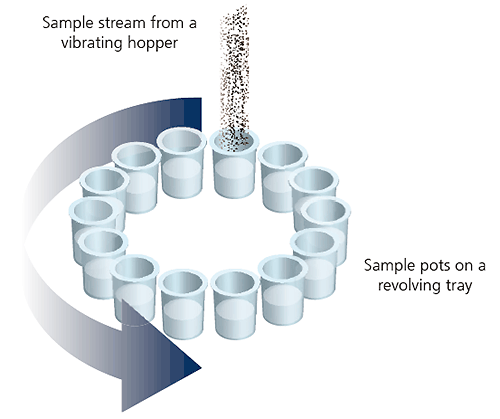

Eine gängige, vielfach angewandte Methode zur Verbesserung der Fehlerrobustheit bei der Pulverprobenahme ist die Verwendung eines sogenannten Rotationsprobenteilers.

Abbildung 11: Abbildung eines Rotationsprobenteilers.

Im Rotationsprobenteiler fließt das Pulver durch einen Trichter in eine rotierende Anordnung von Behältern. Auf diese Weise kann dem Material in regelmäßigen Abständen eine Reihe von Teilproben entnommen werden. Somit wird sichergestellt, dass selbst bei einer Entmischung der Probe im Trichter jeder Behälter eine repräsentative Teilprobe enthält.

Viele Verfahren zur Partikelcharakterisierung erfordern, dass die zu analysierende Probe in einer dispergierten Form vorliegt, in der die einzelnen Partikel räumlich voneinander getrennt sind. Um dies zu erreichen, gibt es zwei grundlegende Methoden:

Bei der Nassdispergierung werden einzelne Partikel in einem flüssigen Dispergiermittel suspendiert. Durch die Benetzung der Partikeloberflächen mit Dispergiermittelmolekülen wird die Oberflächenenergie gesenkt, womit die Anziehungskräfte zwischen den Partikeln gesenkt werden. Dadurch wird die Trennung und Suspension der Partikel ermöglicht.

Bei Dispergiermitteln mit hoher Oberflächenspannung wie Wasser kann die Beigabe einer kleinen Menge Netzmittel das Benetzungsverhalten und die Partikeldispersion erheblich verbessern.

Um einzelne Partikel zu dispergieren, wird der Probe üblicherweise etwas Energie zugeführt. Dies geschieht häufig durch Rühren oder Agitation. Für sehr feine Materialien oder stark gebundene Agglomerate wird gelegentlich Ultraschall eingesetzt.

Bei mikroskopbasierten Verfahren können nasse Methoden zur Probenvorbereitung eingesetzt werden, um die Probe zunächst in Dispersion auf einem Objektträger aufzubringen. Nach Verdampfung des Dispergiermittels kann eine Analyse der dispergierten Partikel im trockenen Zustand erfolgen.

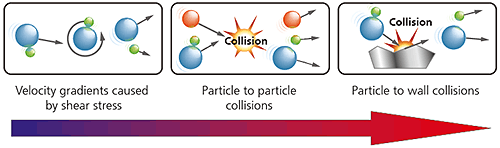

Bei der Trockendispergierung ist das Dispergiermittel üblicherweise ein Gasstrom, meist saubere, trockene Luft. Systembedingt ist der Energieaufwand bei der Trockendispergierung üblicherweise höher als bei der Nassdispergierung. Wie unten dargestellt wirken drei unterschiedliche Typen von Dispergiermechanismen auf die Probe ein. In der Reihenfolge zunehmender Energiezufuhr sind dies:

Abbildung 12: Veranschaulichung der drei Mechanismen zur Trockenpulverdispergierung mit zunehmender Energie/Aggressivität.

Welcher Dispergiermechanismus dominiert, hängt von der Konstruktion der Dispergiereinheit ab, wobei Partikel-Wand-Kollisionen eine aggressivere Hochenergiedispergierung bieten als Partikel-Partikel-Kollisionen und Scherkräfte.

Da bei der Trockendispergierung keine Entsorgung von teuren und häufig gefährlichen Lösungsmitteln erforderlich ist, stellt sie eine attraktive Option dar. Trockendispergierung ist jedoch nicht für sehr feine Pulver (< 1 Mikrometer) geeignet, da die hohen Partikel-Partikel-Anziehungskräfte in diesen Materialien sehr schwer zu überwinden sind. Vorsicht ist auch bei empfindlichen Partikeln geboten, um sicherzustellen, dass der Probe nicht mehr Energie als zur Dispergierung nötig zugeführt wird und die Partikel bei der Dispergierung nicht zerstört werden. In derartigen Fällen sollte eine Nassdispergiermethode als Referenz zur Methodenvalidierung verwendet werden.

Laserbeugung ist eine weit verbreitete Technik zur Partikelgrößenmessung für Materialien mit einer Größe von mehreren Hundert Nanometern bis zu mehreren Millimetern. Die Hauptgründe für den Erfolg dieser Technik sind:

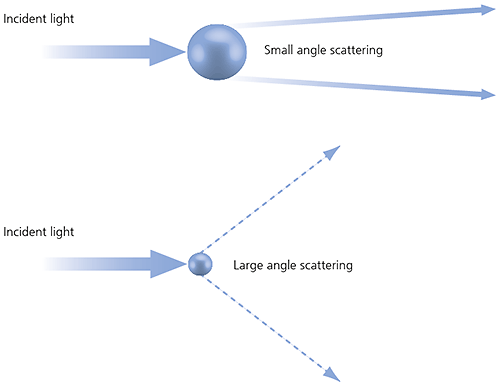

Bei der Laserbeugung werden Partikelgrößenverteilungen durch Messung der Winkelabhängigkeit der Intensität von gestreutem Licht eines Laserstrahls, der eine dispergierte Partikelprobe durchdringt, ermittelt. Wie unten dargstellt, streuen große Partikel Licht mit kleinen Winkeln relativ zum Laserstrahl, während kleine Partikel zu großen Streuwinkeln führen. Die Daten der winkelabhängigen Streulichtintensität werden analysier und sind die Basis zur Berechnung der Größe der Partikel, die für das Beugungsmuster verantwortlich sind. Dabie wird die Mie-Theorie genutzt. Die Partikelgröße wird als Durchmesser der volumengleichen Kugel angegeben.

Abbildung 13: Streuung von Licht an großen und kleinen Partikeln.

Bei der Laserbeugung wird die Mie-Theorie der Lichtstreuung zur Berechnung der Partikelgrößenverteilung verwendet. Dabei wird ein volumengleiches Kugelmodell angenommen.

Die Mie-Theorie erfordert Kenntnisse der optischen Eigenschaften (Brechungsindex und Imaginärteil) sowohl des Dispergiermittels als auch der zu messenden Probe.

Meist sind die optischen Eigenschaften des Dispergiermittels problemlos Veröffentlichungen zu entnehmen und viele moderne Geräte sind mit integrierten Datenbanken ausgestattet, die häufig verwendete Dispergiermittel enthalten.

Bei Proben, deren optische Eigenschaften nicht bekannt sind, kann der Anwender diese entweder messen oder anhand eines iterativen Ansatzes schätzen, der auf einer Angleichung der modellierten Daten und der tatsächlich gemessenen Daten basiert.

Ein vereinfachter Ansatz ist die Fraunhofer-Näherung, für die die optischen Eigenschaften der Probe nicht benötigt werden. Bei der Arbeit mit Proben, die Partikel mit einer Größe von weniger als 50 µm oder relativ transparente Partikel enthalten können, ist diese Methode jedoch mit Vorsicht zu genießen.

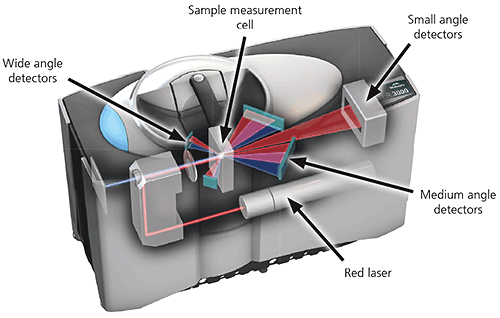

Ein typisches Laserbeugungssystem besteht aus drei Hauptelementen:

1. Optische Bank. Eine dispergierte Probe durchläuft den Messbereich der optischen Bank, in dem die Partikel mit einem Laser bestrahlt werden. Mehrere Detektoren messen mit hoher Genauigkeit in einem weiten Winkelbereich die Intensität des an den Partikeln in der Probe gestreuten Lichts.

Abbildung 14: Optischer Aufbau eines modernen Laserbeugungsgeräts.

2. Probendispergiereinheiten. Die Probenhandhabung und -dispergierung erfolgt mithilfe von Probendispergiereinheiten, die eine Nass- oder Trockenmessung der Probe ermöglichen. Mit ihnen wird sichergestellt, dass die Partikel in der richtigen Konzentration und einem geeigneten, stabilen Dispergierungszustand in den Messbereich der optischen Bank gelangen.

In Nassdispergiereinheiten wird ein wasser- oder lösungsmittelbasiertes flüssiges Dispergiermittel zum Dispergieren der Probe verwendet. Um die Probe suspendiert und homogen zu halten, wird sie in der Messzone kontinuierlich umgewälzt.

Bei Trockenpulver-Probendispergiereinheiten wird die Probe in einem Gasstrom (i. d. R. in trockener Luft) dispergiert. Üblicherweise passiert die gesamte Probe die Messzone nur einmal. Deshalb ist eine Datenerfassung bei hohen Geschwindigkeiten wünschenswert (typischerweise bis zu 10 kHz), um eine repräsentative Probenmessung zu gewährleisten.

3. Gerätesoftware. Die Gerätesoftware steuert das System während des Messvorgangs und analysiert die Beugungsdaten zur Berechnung der Partikelgrößenverteilung. Bei anspruchsvolleren Geräten bietet sie zudem sowohl sofortiges Feedback während der Entwicklung von Methoden als auch eine fachliche Einschätzung der Qualität der Ergebnisse.

Die Anwendung der Laserbeugung ist in der internationalen Norm ISO 13320: 2009 beschrieben. Diese empfiehlt sich als Lektüre, wenn Sie dieses Verfahren routinemäßig einsetzen möchten.

Die dynamische Lichtstreuung (DLS - Dynamic Light Scattering), mitunter als Photonenkorrelationsspektroskopie (PCS) oder quasielastische Lichtstreuung (QELS) bezeichnet, ist ein nichtinvasives, etabliertes Verfahren zur Messung der Größe von Partikeln und Makromolekülen, die typischerweise im Submikrometer- bis Nanometerbereich liegen kann. Mit diesem Verfahren können Proben gemessen werden, die aus in einer Flüssigkeit suspendierten Partikeln bestehen, wie z. B. Proteine, Polymere, Mizellen, Kohlenhydrate, Nanopartikel, kolloidale Dispersionen und Emulsionen.

Zu den wichtigsten Vorteilen gehören:

Die suspendierten Partikel führen eine brownsche Molekularbewegung aus, die durch die thermisch induzierten Kollisionen zwischen den Partikeln und den Lösungsmittelmolekülen hervorgerufen wird.

Werden die Partikel mit einem Laser bestrahlt, schwankt die Intensität des gestreuten Lichts in sehr kurzen Zeitskalen mit einer Frequenz, die von der Partikelgröße abhängt. Kleinere Partikel werden von den Lösungsmittelmolekülen stärker abgelenkt und bewegen sich schneller. Die Analyse dieser Intensitätsschwankungen ergibt die Geschwindigkeit der Brownschen Molekularbewegung und daraus errechnet sich mithilfe der Stokes-Einstein-Beziehung die Partikelgröße.

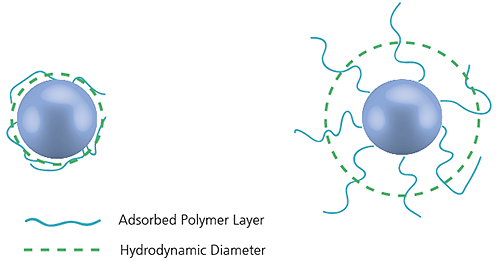

Der mittels dynamischer Lichtstreuung gemessene Durchmesser wird hydrodynamischer Durchmesser genannt und bezieht sich auf die Diffusionseigenschaften eines Partikels in einer Flüssigkeit. Der mit diesem Verfahren ermittelte Durchmesser ist der einer Kugel, die dieselben translationalen Diffusionskoeffizienten aufweist wie das gemessene Partikel.

Abbildung 15: Veranschaulichung des mittels DLS gemessenen hydrodynamischen Radius, der größer als der „Kerndurchmesser“ ist.

Der translationale Diffusionskoeffizient ist nicht nur von der Größe des „Partikelkerns“ abhängig, sondern auch von der Oberflächenstruktur sowie von der Konzentration und der Art der Ionen in dem Medium. Daher ist der so ermittelte Durchmesser z. B. größer als bei einer Messung mittels Elektronenmikroskopie, bei der das Partikel aus seiner ursprünglichen Umgebung entfernt wird.

Anzumerken ist, dass es die dynamische Lichtstreuung eine intensitätsgewichtete Partikelgrößenverteilung ergibt. Somit kann das Vorhandensein übergroßer Partikel im Partikelgrößenergebnis dominieren.

Ein übliches DLS-Gerät enthält eine Laserlichtquelle, deren Licht mithilfe einer Optik auf die Probe fokussiert wird. Das Licht wird von den Partikeln in alle Richtungen gestreut. Ein einzelner Detektor, üblicherweise in einem 90° Winkel zum Laserstrahl platziert, erfasst die Streulichtintensität. Die Intensitätsschwankungen des Streulichts werden in elektrische Impulse umgewandelt, die einem digitalen Korrelator zugeführt werden. Dieser generiert die Autokorrelationsfunktion, aus der die Partikelgröße berechnet wird.

Bei modernen Geräten werden durch das nichtinvasive Rückstreuungsverfahren (NIBS - Non-Invasive Back-Scatter) die Bereiche der messbaren Größen und Konzentrationen von Proben erweitert.

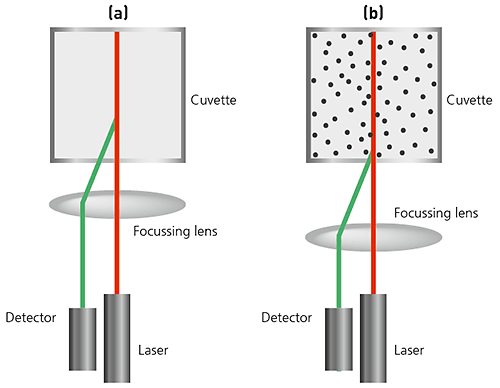

Zur Größenmessung wird bei diesen Geräten das Streulicht bei 173° gemessen, wie nachstehend gezeigt. Dieses Prinzip wird als Rückstreudetektion bezeichnet. Da zudem die Optik nicht in Kontakt mit der Probe kommt, wird die Detektionsoptik als nichtinvasiv bezeichnet.

Die Anwendung des nichtinvasiven Rückstreuungsverfahrens bietet viele Vorteile:

Abbildung 16: Illustration eiens NIBS-basierenden DLS-Systems. a) Bei kleinen Partikeln oder Proben mit niedrigen Konzentrationen ist es vorteilhaft, ein möglichst starkes Streulicht von der Probe zu erhalten Wenn der Laserstrahl die Küvettenwand passiert, erzeugt der Unterschied des Brechungsindex der Luft und des Küvettenmaterials Lichtreflexe. Diese Lichtreflexe können das Signal von den streuenden Partikeln verfälschen. Durch Verlagern der Messposition von der Küvettenwand zur Mitte der Küvette kann dieser Effekt eliminiert werden. (b) Große Partikel oder Proben mit hohen Konzentrationen streuen das Licht stärker. Hier können durch eine Messposition näher zur Küvettenwand Mehrfachstreuungen vermieden werden, indem die Weglänge minimiert wird, die das Streulicht zurücklegen muss.

Die automatisierte Bildanalyse ist ein hochauflösendes direktes Verfahren zur Charakterisierung von Partikeln mit einer Größe von ca. 1 Mikrometer bis zu mehreren Millimetern. Einzelne Partikelbilder einer dispergierten Probe werden erstellt und analysiert, um Partikelgröße, Partikelform und andere physikalische Eigenschaften zu ermitteln. Durch die Messung von Zehntausenden bis Hunderttausenden von Partikeln pro Messzyklus können statistisch repräsentative Verteilungen konstruiert werden.

Für statische Bildanalysesysteme ist eine stationär dispergierte Probe erforderlich, während die Probe bei dynamischen Bildanalysesystemen an der Bilderfassungsoptik vorbeifließt. Das Verfahren wird häufig in Verbindung mit kollektiven Methoden zur Partikelgrößenbestimmung wie der Laserbeugung verwendet, um ein tieferes Verständnis der Probe zu erlangen oder die kollektiven Messungen zu validieren. Zu den typischen Anwendungen gehören:

Ein typisches automatisiertes Bildanalysesystem besteht aus drei Hauptelementen:

1. Probenpräsentation und -dispergierung

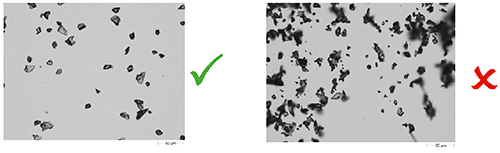

Dieser Schritt ist für gute Ergebnisse unerlässlich. Ziel dieses Schritts ist die räumliche Trennung von einzelnen Partikeln und Agglomeraten im Sichtfeld. Zur Probenpräsentation steht je nach der Art der Probe und der verwendeten Geräte eine Auswahl von Methoden zur Verfügung. Bei der dynamischen Bildanalyse wird eine Durchflusszelle eingesetzt, die die Probe während der Messung passiert. Für die statische Bildanalyse wird eine ebene Oberfläche benötigt, wie z. B. ein Objektträger, eine Glasplatte oder eine Filtermembran. Automatisierte Dispergiermethoden sind wünschenswert, um potenzielle bedienungsbedingte Schwankungen zu vermeiden.

Abbildung 17: Veranschaulichung der Bedeutung der Probendispersion für die automatisierte Partikelbildanalyse.

2. Bilderfassungsoptik

Die Bilder der einzelnen Partikel werden mithilfe einer digitalen CCD-Kamera erfasst. Dabei muss die Vergrößerung der Optik für die jeweilige Probe geeignet sein. Bei dynamischen Bildanalysesystemen wird die Probe üblicherweise von hinten beleuchtet. Statische Bildanalysesysteme bieten bei der Probenbeleuchtung mehr Flexibilität (z. B. Auflicht, Durchlicht, Dunkelfeld usw.). Für doppelbrechende Materialien wie Kristalle können auch polarisierende Optiken eingesetzt werden. Die leistungsfähigsten dynamischen Bildanalysesysteme verfügen über einen hydrodynamischen Mantelstrommechanismus, um selbst bei sehr feinen Partikeln eine einheitliche Fokussierung zu erzielen.

Abbildung 18: Veranschaulichung des optischen Aufbaus bei statischer Bildanalyse (links) und dynamischer Bildanalyse (rechts).

3. Datenanalysesoftware

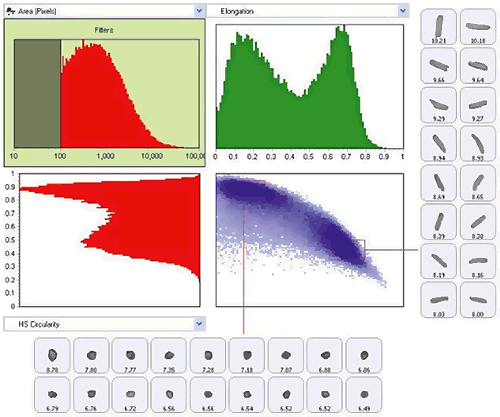

Die typischen Geräte messen und protokollieren für jedes Partikel eine Reihe von morphologischen Eigenschaften. Bei den leistungsfähigsten Geräten sorgen Softwareoptionen zur Erstellung von Grafiken und zur Datenklassifizierung dafür, dass das Extrahieren der relevanten Daten der Messung über eine intuitive grafische Benutzeroberfläche so einfach wie möglich ist. Einzeln gespeicherte Graustufenbilder für jedes Partikel ermöglichen die qualitative Verifizierung der quantitativen Ergebnisse.

Abbildung 19: Verwendung eines Scattergramms zur Darstellung der Klassifizierung der Probe nach Größe (Dehnung) und Form (HS-Zirkularität).

Elektrophoretische Lichtstreuung (Electrophoretic Light Scattering, ELS) ist eine Technik zur Messung der elektrophoretischen Mobilität von Partikeln in Dispersion oder Molekülen in Lösung. Diese Mobilität wird häufig in Werte für das Zetapotenzial konvertiert, um Materialien unter verschiedenen experimentellen Bedingungen vergleichen zu können.

Der Technik liegt das grundlegende physikalische Prinzip der Elektrophorese zugrunde. Eine Dispersion wird in eine Zelle mit zwei Elektroden eingeführt. An die Elektroden wird eine elektrische Spannung angelegt, wodurch sich geladene Partikel oder Moleküle in Richtung der entgegengesetzt geladenen Elektrode bewegen. Die Geschwindigkeit dieser Bewegung wird als elektrophoretische Mobilität bezeichnet und ist abhängig vom Zetapotenzial der Partikel.

Diese Geschwindigkeit wird mittels Laser-Doppler-Verfahren gemessen, das mit zwei Methoden implementiert werden kann: Bei der einen Methode wird eine Frequenzverschiebung ermittelt, aus der die vollständige Zetapotenzialverteilung berechnet werden kann. Bei der zweiten, als Phasenanalyse der Lichtstreuung (PALS - Phase Analysis Light Scattering) bezeichneten Methode wird die Phasenverschiebung gemessen. PALS ist empfindlicher, liefert jedoch nur einen Durchschnittswert für das Zetapotenzial.

Bei modernen Messsystemen sind DLS und ELS häufig in einem Gerät kombiniert, sodass sowohl die Partikelgröße als auch das Zetapotenzial gemessen werden können.

Die physikalischen Eigenschaften von partikulären Materialien haben auch einen Einfluss auf die Volumen- oder Makroeigenschaften von Produkten und Materialien.

So kann z. B. das rheologische Verhalten (Fließ- und Verformungsverhalten) eines formulierten Produkts direkt in Zusammenhang mit den Eigenschaften seiner Inhaltsstoffe gesetzt werden (wie Partikelgröße, Partikelform und Suspensionsstabilität). Daher liefert die Messung der Rheologie einer Formulierung Aufschluss über deren kolloidalen Zustand und die Wechselwirkungen zwischen den verschiedenen Bestandteilen. Rheologische Messungen ermöglichen Prognosen der Eigenschaften einer Formulierung, wie z. B:

Daher ist es bei der Arbeit mit partikulären Formulierungen auch wichtig, Makroeigenschaften wie die Rheologie zu berücksichtigen, um das Verhalten formulierter Materialien besser zu verstehen. Eine detaillierte Erörterung der Theorie und Anwendung der Rheologie würde den Rahmen dieser Publikation sprengen. Auf der Website von Malvern Panalytical finden Sie hierzu jedoch diverse einführende Literatur.

Application note : Basic principles of particle size analysis

Webinar : An introduction to particle size

Webinar: Particle size Masterclass 1: The basics

Webinar: Particle size Masterclass 2: Which technique is best for me?

Webinar: Particle sizing Masterclass 3: Method development

Webinar: Particle size Masterclass 4: Setting specifications

Article: Particle shape - An important parameter

Webinar : Imaging Masterclass 1: Basic principles of particle characterizationby automated image analysis

Technical note: Zeta potential: An introduction in 30 minutes

Gy, P., Sampling of Particulate Materials, Theory and Practice, 2nd Edition, Elsevier, Amsterdam (1982)

Whitepaper: Sampling for particle size analysis

Webinar : Estimation of fundamental sampling error in particle size analysis

Webinar: Laser diffraction Masterclass 1: Laser diffraction explained

Webinar: Laser diffraction Masterclass 2: Wet method development

Webinar: Laser diffraction Masterclass 3: Dry method development

Webinar: Laser diffraction Masterclass 4: Optical properties

Webinar: Laser diffraction Masterclass 5: Setting particle size specifications

Webinar: Laser diffraction Masterclass 6: Troubleshooting

Webinar: Laser diffraction Masterclass 7: Comparison of light scattering and image analysis techniques

ISO 13320:2009 Partikelgrößenanalyse - Laserbeugungsverfahren

Whitepaper: The enduring appeal of laser diffraction particle size analysis

Technical note: Dynamic light scattering: An Introduction in 30 Minutes

Whitepaper: Dynamic light scattering: common terms defined

Technical note: Zeta potential: An introduction in 30 minutes

Webinar : Imaging Masterclass 1: Basic principles of particle characterizationby automated image analysis

Webinar: Imaging Masterclass 2: Sample preparation techniques for particle size and shape measurements

Webinar: Imaging Masterclass 3: Static vs. dynamic image analysis

ISO 13322-1:2014 Partikelgrößenanalyse - Bildanalyseverfahren - Teil 1: Statische Bildanalyseverfahren

ISO 13322-2:2006 Partikelgrößenanalyse - Bildanalyseverfahren - Teil 2: Dynamische Bildanalyseverfahren